Demo Chat IA

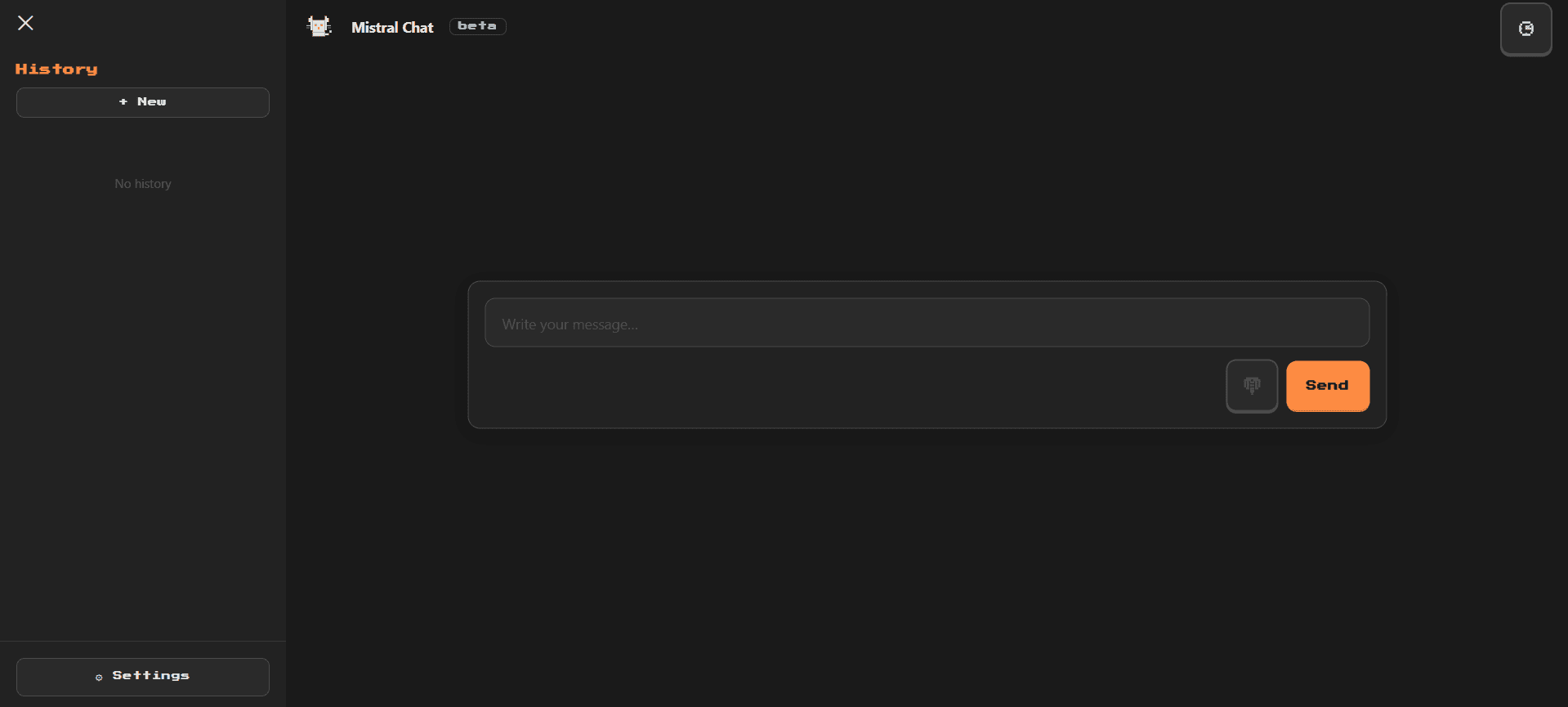

LiveInterfaz de chat con Mistral AI y streaming

Sobre el proyecto

Una aplicación web de chat moderna que demuestra las capacidades de Mistral AI. Construida con Next.js 14 y desplegada en Vercel Edge, implementa streaming de respuestas en tiempo real para una experiencia de usuario fluida y responsiva. El proyecto explora las mejores prácticas de integración de LLMs en aplicaciones web, incluyendo manejo de contexto, optimización de prompts, y gestión eficiente del estado de conversación.

Tecnologías

Next.jsMistral AITypeScriptEdge FunctionsStreaming

Características

- Streaming de respuestas en tiempo real

- Interfaz de chat moderna y responsiva

- Manejo de contexto de conversación

- Edge Functions para latencia mínima

- Optimización de prompts para mejores respuestas

- Gestión de estado con React hooks

- Diseño dark mode minimalista

- Despliegue automático con Vercel

Desafíos técnicos

- Implementación de streaming SSE (Server-Sent Events)

- Manejo correcto del contexto entre múltiples mensajes

- Optimización del rendimiento en Edge Runtime

- Gestión de errores y reconexión automática

- Balance entre latencia y calidad de respuestas

Aprendizajes

- Integración de LLMs con APIs modernas

- Arquitectura serverless con Edge Functions

- Patrones de streaming en aplicaciones web

- Optimización de prompts para LLMs

- Despliegue y monitoreo de apps en Vercel Edge

Capturas de pantalla

Vista 1

Proyecto personal sin afiliación oficial con Mistral AI.